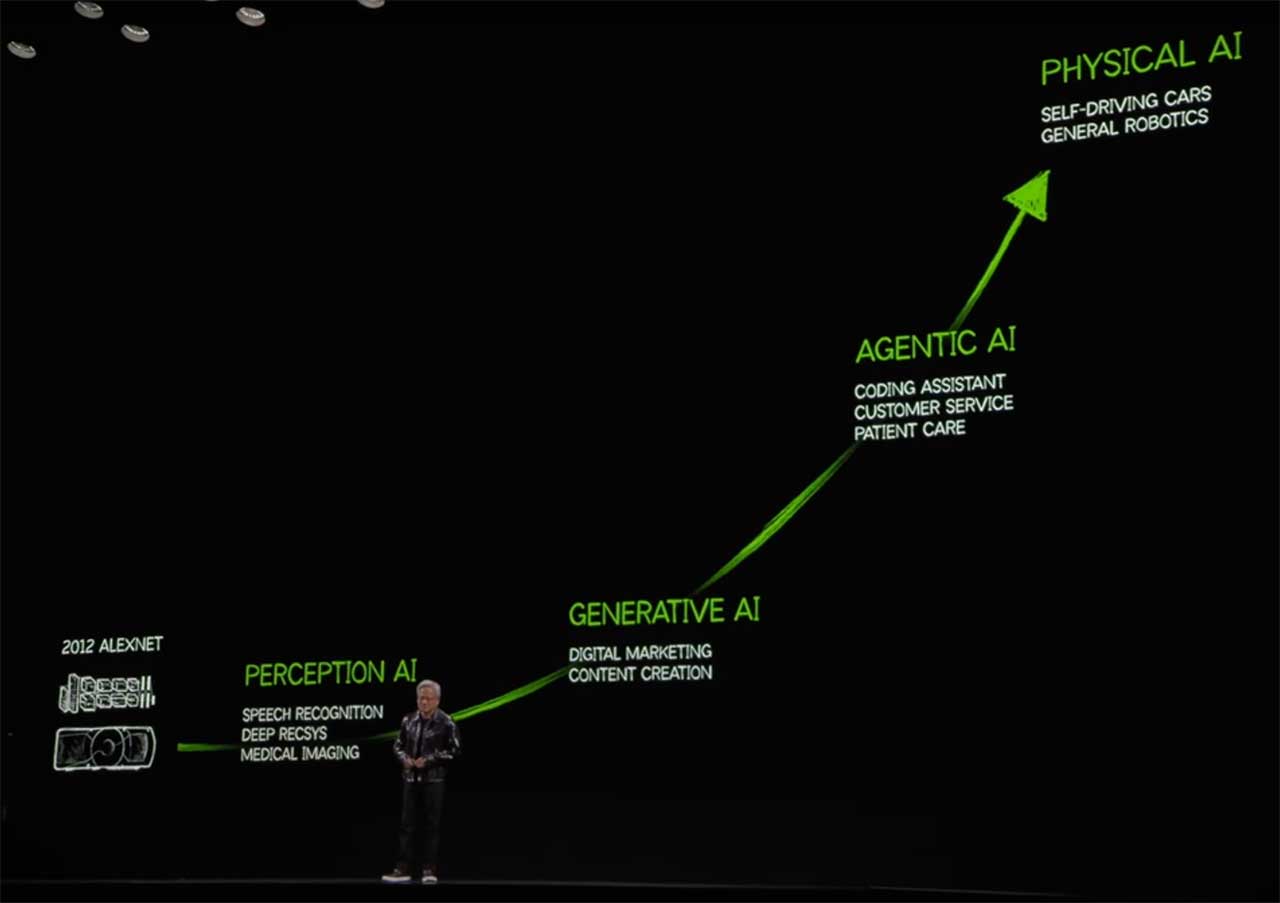

2025年3月18日,NVIDIA 首席执行官黄仁勋在加利福尼亚州圣何塞 SAP 中心发表 GTC 2025主题演讲,谈到代理 AI、机器人、加速计算等领域的未来发展。

黄仁勋重复在 CES 2025 上主题演讲的 AI 技术发展的路径。

六位未满25岁的科技天才是马斯克DOGE(政府效率部)的“六君子”(《每日邮报》称为“书呆子大军”)。他们手握AI、数据科学和自动化技术,意图用代码取代政客,用算法消灭低效,以科技之力撬动整个国家机器。

由于信奉(1)未来十年全球风险集中在环境、技术和社会治理(世界经济论坛《2024年全球风险报告》),和(2)全球治理转型、人工智能技术和特朗普新政加速旧国际秩序崩溃这两个理论和判断,转发本文以介绍人工智能、数据科学和自动化应用于社会治理。

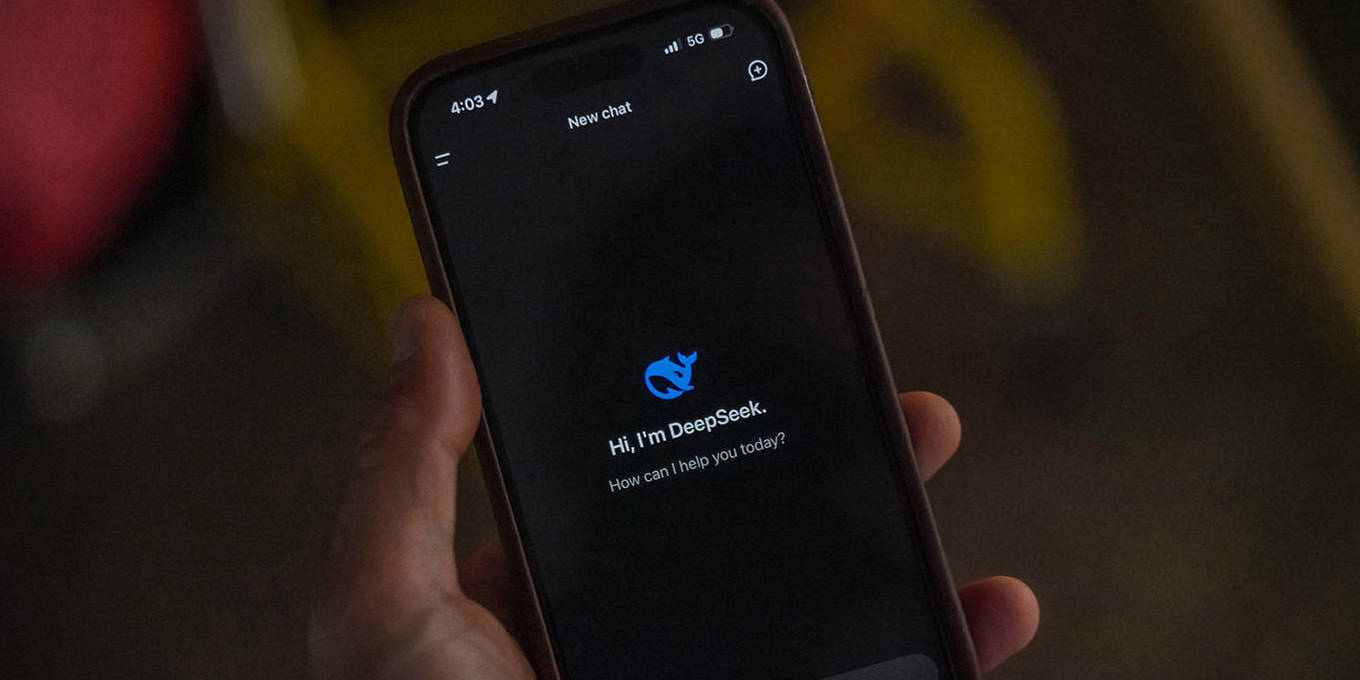

深度求索(DeepSeek)是由中国对冲基金幻方(High-Flyer)创立和支持的人工智能公司。2024年12月,该公司将其人工智能模型 DeepSeek-V3 版作为开源发布,声称该模型可与 OpenAI 和谷歌的模型相媲美,但训练成本仅为 560 万美元(尚不清楚具体包括哪些支出,但推测是该模型使用 2,048 个 NVIDIA H800 GPU 进行了约两个月预训练的 GPU 成本)。

DeepSeek在网页端、APP 和 API 全面上线,可以写代码、读文件、写作各种创意内容,该模型正受到越来越多的关注。在Vibe-Eval基准测试中是迄今为止排名最高的公开授权模型,也是目前最大的公开授权模型,比 Meta 公司最大的 Llama 系列模型 Llama 3.1 405B 还要大得多。

2025 年 1 月 6 日,NVIDIA 推出了 NVIDIA® Project DIGITS,这是一款个人 AI 超级计算机,可让全球的 AI 研究人员、数据科学家和学生使用 NVIDIA Grace Blackwell 平台的强大功能。

Project DIGITS 采用全新的 NVIDIA GB10 Grace Blackwell 超级芯片,提供千万亿次的 AI 计算性能,可用于原型设计、微调和运行大型 AI 模型。

ChatGPT 将生成式 AI 带入主流已有一年多时间。在此期间,我们对大型语言模型(LLM)的当前效用和未来影响感到兴奋不已。这些工具每周已有数亿用户,分析师预计它们将为经济贡献数万亿美元,而且现在 OpenAI 的可靠竞争对手越来越多。

然而,人们也有很多担忧。企业恐怖故事、政策限制和幻觉让人们对部署 GenAI 犹豫不决,这是可以理解的,而普遍的技术恐惧症意味着全球大多数人仍未尝试过它。即使在全球十亿知识工作者中,也只有 10% 的人定期使用 ChatGPT(占有60% 的市场份额)。在使用过 ChatGPT 的人中,许多人抱怨它根本没用:“当我想到 ChatGPT 时,我脑海中没有出现任何用例,每个人都为它疯狂,”一位用户哀叹道。其他人则认为这项技术存在错误:“它在很多事情上都完全错误,让我对它的所有答案都产生了怀疑,”另一位用户说。

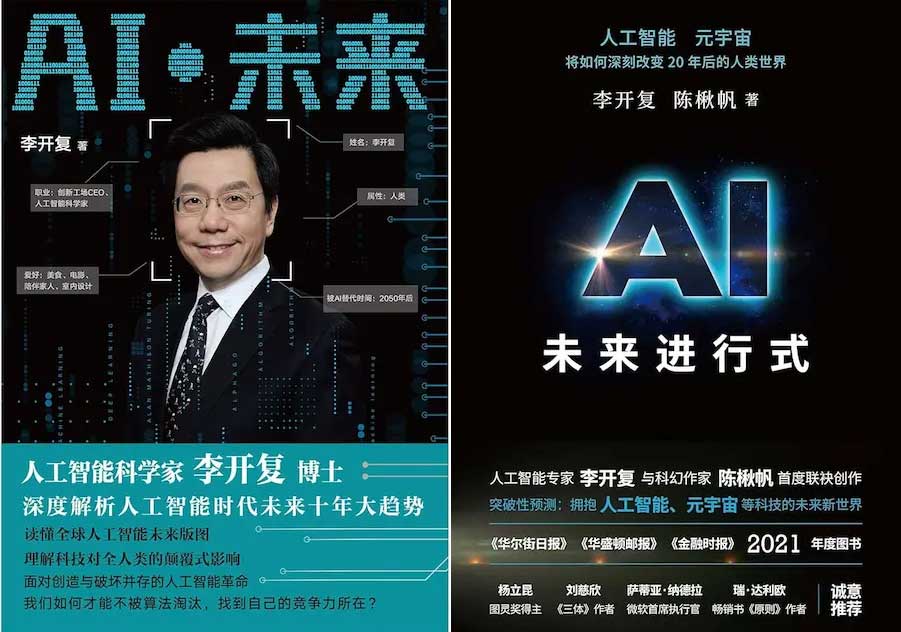

阮一峰在科技爱好者周刊(第 330 期)中结合李开复的《AI·未来》(浙江人民出版社,2018)和《AI·未来进行式》(浙江人民出版社,2022)两本书,梳理了书中阐述的人工智能概念。

李开复(Kai-Fu Lee)本是一名计算机科学家,获得哥伦比亚大学计算机科学学士学位和卡内基梅隆大学计算机科学博士学位,主要研究语音识别,曾在Apple和Silicon Graphics的技术部门工作,并领导Microsoft和Google的中国部门。在打工近20年后,李开复建立了风险投资基金创新工场(Sinovation Ventures),为早期互联网初创公司提供种子资金。2023 年,李开复创立了人工智能初创公司 01.AI,专注于为中国市场构建大型语言模型。