推动人工智能发展的因素有三个:算法创新、数据,以及可用于训练的计算量。OpenAI的算力趋势报告表示,自2012年以来,在最大规模的人工智能训练中所使用的计算量呈指数级增长,3.5个月的时间翻一倍(相比之下,摩尔定律是18个月的倍增周期)。

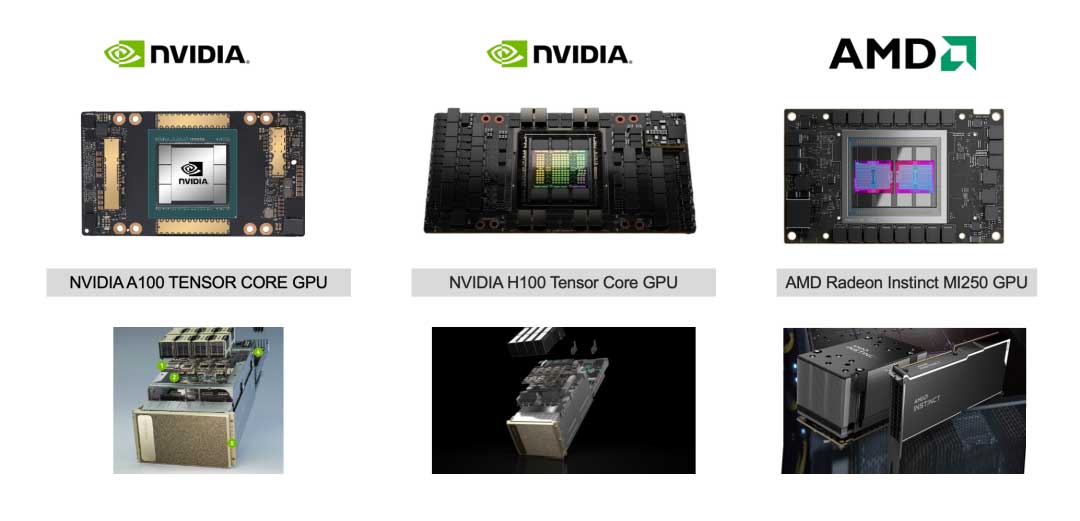

NVIDIA A100/H100和AMD MI100/MI250是目前性能最强的GPU,它们是人工智能数据超算中心的高性能核心处理芯片。

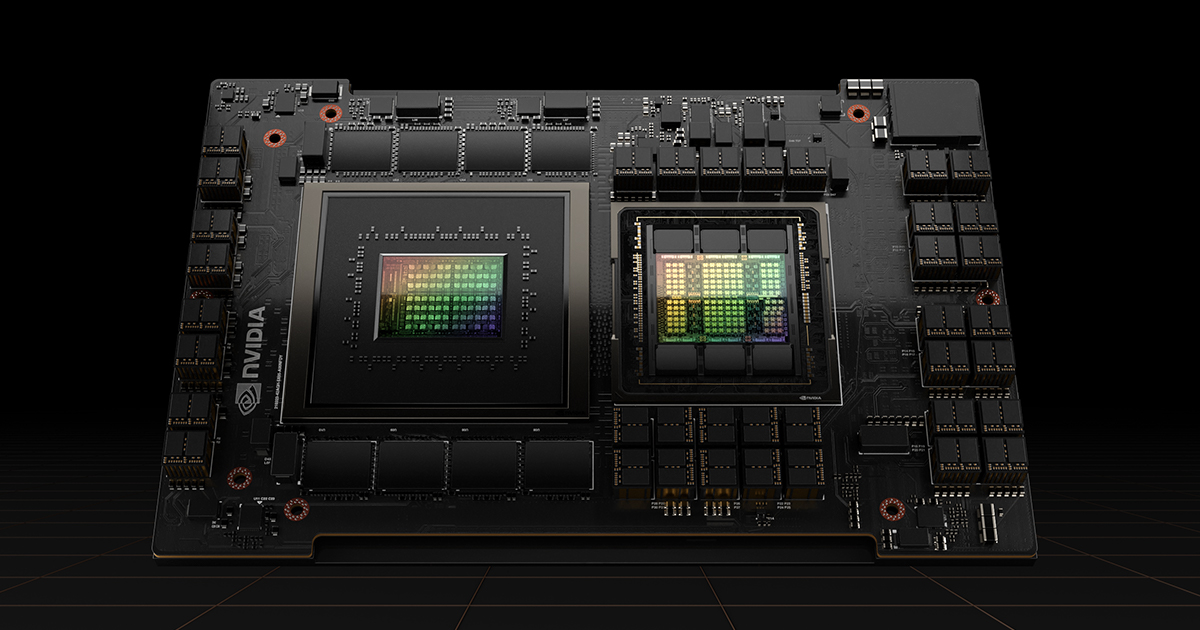

NVIDIA A100

NVIDIA A100 由 NVIDIA Ampere 架构提供支持,内核为GA100,是 NVIDIA 数据中心平台的引擎。A100 提供比上一代产品高出 20 倍的性能,并且可以划分为七个 GPU 实例以动态调整以适应不断变化的需求。

A100 是英伟达2020年推出,采用台积电为英伟达定制的7 nm工艺,拥有540亿个晶体管。A100 拥有 6,912 个 FP32 CUDA 内核、3,456 个 FP64 CUDA 内核和 422 个 Tensor 内核,能够在 FP16 工作负载下产生 312 TeraFLOPs。A100 以 DGX A100 数据运算中心打包出售,该系统包含 8 个 A100芯片、一对 64 核 AMD 服务器芯片、1TB RAM 和 15TB NVME 存储,售价高达 200,000 美元。

为了训练出 Stable Diffusion,研究团队动用了 4000 个 A100 Ezra-1 AI 超大集群。

NVIDIA H100

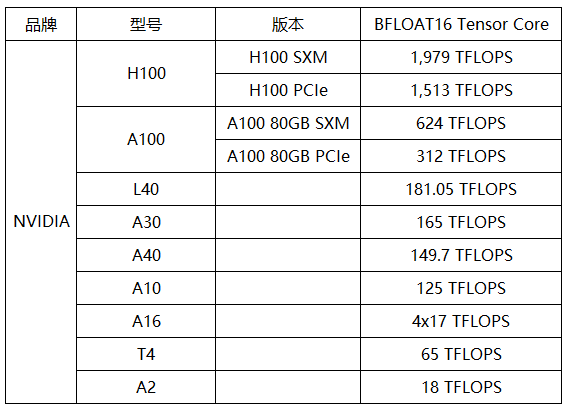

NVIDIA H100是英伟达2022年推出,采用台积电为英伟达定制的4 nm工艺,拥有800亿个晶体管,是有史以来世界上最先进的芯片,基于NVIDIA的下一代架构NVIDIA Hopper和内核GH100,能够在 FP16 工作负载下产生 1513 TeraFLOPs,性能比A100高6倍。

H100计算卡采用SXM和PCIe 5.0,AI计算系统DGX H100则集成了八个H100芯片和两个PCIe 5.0 CPU处理器。

2022 年 3 月 21 日,英伟达首席执行官黄仁勋在GTC 2022透露了采用 Hopper 架构的 H100 GPU 计划。系统合作伙伴包括源讯、思科、戴尔、富士通、技嘉、新华三、汇和、浪潮、联想、宁昌和魏超。云服务合作伙伴包括阿里云、亚马逊云、百度云、谷歌云、微软Azure、甲骨文云、腾讯云。

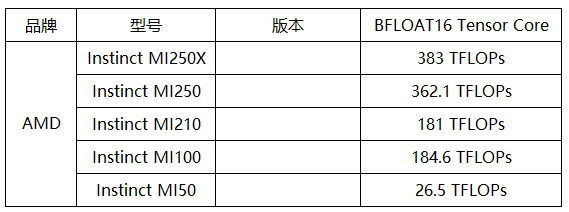

AMD MI100

2020年11月,AMD以AMD Instinct MI100宣称进入百亿亿级(10TF)新时代,采用 AMD CDNA 架构并具有 120 个计算单元(7,680 个核心),提供最高可达 184.6 TFLOPs FP16 和 92.3 TFLOPs bFloat16 的峰值性能。

AMD MI250

AMD Instinct MI200系列是AMD 2021年推出的ExaScale百亿亿次级别加速卡,采用新的CDNA2计算架构,有高性能的Instinct MI250X和精简的Instinct MI250两款。AMD Instinct MI250采用台积电的6nm FinFET工艺,拥有582亿个晶体管,能够在 FP16 工作负载下产生 362.1 TeraFLOPs。

Instinct MI200系列GPU以OAM与PCIe两种形式版本提供。

AMD Instinct MI200系列已经赢得戴尔、技嘉、联想、惠普、华硕等HPC和AI合作伙伴。尤其是与美国国防部橡树岭国家实验室、HPE合作打造的超级计算机“Frontier”,采用第三代霄龙处理器、MI250X加速卡,峰值算力高达150亿亿次浮点计算每秒。

2022年,美国发布禁止向中国出口 Nvidia 和 AMD 的高性能(计算能力和数据传输率) GPU 芯片的禁令,涉及A100 和 MI250,并将影响到H100。

现在,人们对 ChatGPT 或 Stable Diffusion 等生成式人工智能模型的兴趣激增,计算量不足将影响到中国人工智能的进步(指高性能处理芯片缺乏造成人工智能训练需要的大规模算力缺乏,在应用领域则不受影响,众多消费级AI芯片(CPU、GPU、TPU)可以满足日常的图像处理、机器视觉、机器学习、深度学习和人工神经网络)。

为符合出口限制法规,NVIDIA 向中国市场推出定制版AI加速卡A800、H800,分别是A100、H100的性能限制版本。在使用大量数据训练人工智能模型时,传输速度非常重要,因为较慢的传输速度意味着更多的训练时间。

NVIDIA & AMD

30年前,硅谷研发图形处理芯片的公司群雄逐鹿,如今几乎只剩NVIDIA(英伟达)和AMD(超微)。

早期的深度学习研究使用了现成的 GPU 加速卡,如NVIDIA GPU的主要产品GeForce、Quadro和Tesla:

- 游戏卡:GeForce系列面向图像用户,通常用于桌面显示;

- 专业卡:Quadro系列用于专业绘图设计,支持高速OpenGL渲染;

- 计算卡:Tesla系列用于大规模的并行计算,专为处理计算类应用程序而设计。

但NVIDIA已经建立了一条单独的数据中心 GPU 产品线,专为科学和人工智能工作负载量身定制,用以在数据中心或边缘解决深度学习和 AI、HPC、图形或虚拟化方面的业务问题。

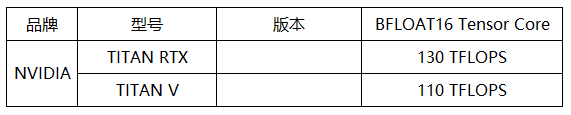

此间,NVIDIA还从桌面GeForce GTX独立出一个TITAN系列,采用计算卡核心,定位一直从高端游戏、4K/VR游戏进化到神经网络运算,放眼于AI人工智能、深度计算、机器学习。

NVIDIA TITAN V(2017)采用Volta架构,拥有 12 GB HBM2 内存和 640 个 Tensor 核心的强大功能,可提供 110 TFLOPS 的性能。

NVIDIA TITAN RTX(2018)由 Turing 架构提供支持,带来 130 TFLOPS 的性能、576 个 Tensor 核心和 24 GB 超快 GDDR6 内存。

NVIDIA官方的GPU算力(Compute Capability)表,请注意Compute Capability并不代表TFLOPS。关于算力单位的更多介绍,以及一些消费级游戏显卡的浮点性能,可参考《Jetson Nano 2GB 开发套件动手玩》的附文内容。

AMD方面在深度学习领域也颇有建树,但目前集中在数据中心领域。

AMD Instinct产品线旨在加速深度学习、人工神经网络和高性能计算/GPGPU应用,前身为AMD FirePro S系列。基于AMD CPU 和AMD Instinct GPU 的超级计算机比较多,并且用于众多计算机厂商的特色服务器解决方案。

NVIDIA与深度学习

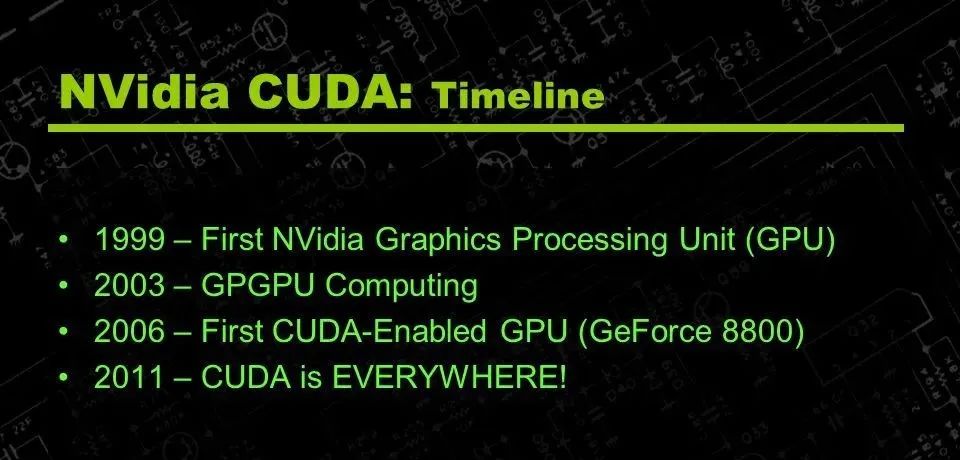

1999 年,NVIDIA推出了号称是世界上第一款官方GPU——GeForce 256。2006 年发布了一个名为CUDA(Compute Unified Device Architecture)的软件工具包,这是一种截然不同的计算机程序编写方式。CUDA开发者平台以其易用性和通用性,让GPU可以用于通用超级计算,最终推动NVIDIA迅速扩张为图形处理领域的霸主。

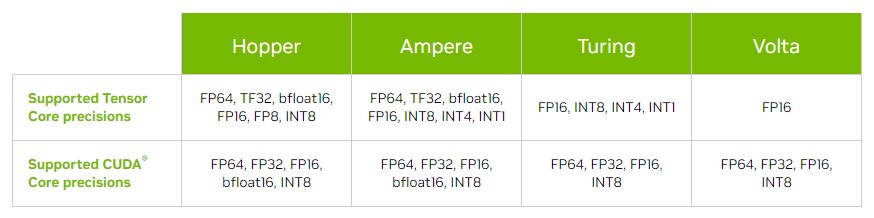

NVIDIA Tensor Core(张量核心)支持混合精度计算,动态调整计算以加速吞吐量,同时保持准确性。Volta是Nvidia继Pascal之后开发的GPU 微架构的代号,是 NVIDIA 首款采用Tensor Core 的芯片,这种专门设计的内核比常规 CUDA 内核具有更卓越的深度学习性能,并配对优化CUDA。第一个使用它的显卡是Tesla V100,它也被用于Titan V等。2018年,NVIDIA Turing 架构发布,这是自 2006 年发明 NVIDIA CUDA GPU 以来最大的飞跃。Tensor Core历经Ampere 架构,现在已经到了第四代 Hopper 架构。

正是因为CUDA以及更为高效的Tensor Core,NVIDIA GPU成为最先进的计算加速器。通过以下链接可以选择兼具CUDA cores和Tensor Core的显卡。

2016年,黄仁勋向OpenA的创始人之一马斯克交付全球首款用于人工智能加速分析的超级计算机DGX-1。此后,OpenAI购买了10000个GPU用于AI计算,NVIDIA开始正式成为人工智能背后的中坚力量。亚马逊为 Hugging Face 公司的 Stability AI 提供了 4,000 多个 Nvidia GPU 对 Stable Diffusion 进行了训练,Stable Diffusion是非常流行的以文本描述生成图像的人工智能模型。

AMD在并购ATI以后,随即公布了代号为AMD Fusion(融聚计划)。简要地说,这个项目的目标是在一块芯片上,集成传统中央处理器和图形处理器。但AMD会继续设计中端以上级别的独立显示核心,因为高端用户和物理计算仍然依赖独立显卡的强大运算性能。

分析师对 AMD 充满信心,这归功于有前途的MI250加速处理单元(APU),这是一种用于密集云计算工作的混合 CPU-GPU-加速器芯片。该公司报告说,到目前为止,在超大规模产品中对该产品进行抽样取得了巨大成功,新的 MI300 也将在 H2'23 推出,并作为劳伦斯利弗莫尔国家实验室(LLNL)世界上最快的超级计算机 El Capitan 的动力。

到 2023 年底,世界上第一台和第二台超级计算机将使用 AMD 市场领先的 APU,这自然建立在公司的战略性 3D 堆叠小芯片之上,通过改进能源性能、数据共享和内存使用来提高计算效率。

TechPowerUp 是一个 PC 硬件媒体,其 GPU 规格数据库有助于了解目标 GPU 的各项参数,并进行对比。另外,评测博主 Tim Dettmers 撰写了万字长文,给出在深度学习中使用 GPU 的经验和建议。

后续

苏姿丰首席执行官展示 Instinct MI300X

2023年6月13日,AMD发布其最先进的用于人工智能的芯片MI300,包括 APU MI300A 及纯 GPU MI300X 是。@AI特刊:AMD发布最强GPU芯片

2023年8月8日,在2023年的电脑图形及互交技术特殊爱好者集团(SIGGRAPH)大会上,英伟达创始人兼首席执行官黄仁勋(Jensen Huang)发布了该公司今年来一直预告的将与AMD的Insight MI300A CPU + GPU对打的产品:DGX GH200 Grace Hopper超级芯片,新型 AI 超级计算机可将 256 个 NVIDIA Grace Hopper 超级芯片完全连接到单个 GPU 中,专为超大规模AI和HPC设计。

2023年10月17日,美国商务部工业和安全局(BIS)公布新的先进计算芯片、半导体制造设备出口管制规则,限制中国购买和制造高端芯片的能力,并将13家中国GPU企业及其子公司添加到实体清单。对比管制条件,英伟达A100、A800、H100、H800、L40S甚至RTX4090等无一幸免,先进芯片唯有V100可用。

AI芯片的未来

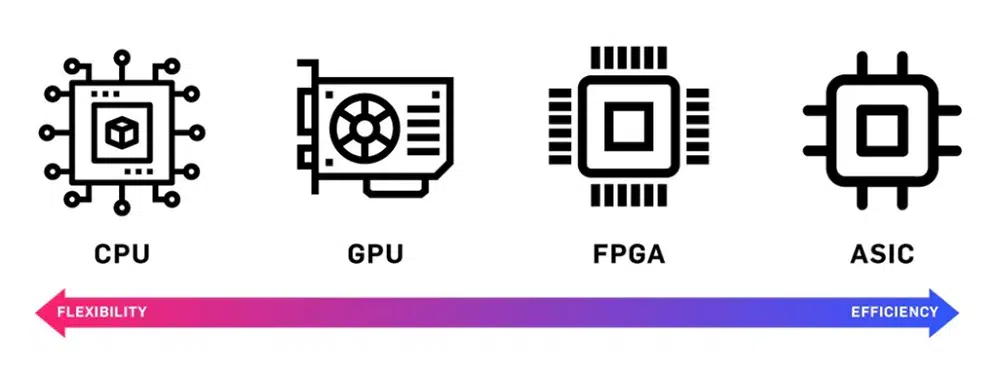

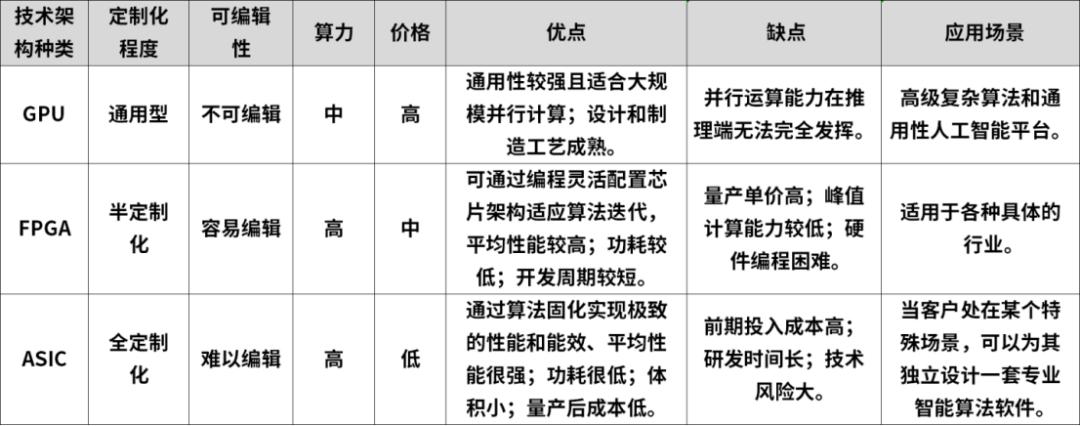

根据技术路径,常见的AI加速芯片可以划分为GPU、FPGA和ASIC三大类别,GPU仅仅是其一。

科技巨头另辟蹊径,在GPU之外寻找更好的底层计算设备。

CPU主要用于逻辑判断、任务调度与控制等;GPU常用于模型训练;FPGA多用于研发阶段、数据中心、AI推理等;ASIC主要面向使用特定AI算法的应用场景,需要相对成熟的应用才能支撑量产。

Google押注定制化的 ASIC 芯片:TPU,专门用于机器学习工作负载。

微软推出ASIC芯片Maia 100,专为 Azure 云服务和 AI 工作负载设计,用于云端训练和推理。

英特尔押注FPGA芯片,FPGA 可重新编程、重新配置的性质使其格外适合应用于飞速演变的人工智能领域,并成立全新独立运营的FPGA公司——Altera。

Arm 近日推出 Ethos-U85 第三代 NPU,专门用于神经网络深度学习。

此外,OpenAI也正在探索自研AI芯片,同时开始评估潜在收购目标。AWS自研AI芯片阵容包括推理芯片Inferentia和训练芯片Trainium。电动汽车制造商特斯拉也积极参与AI加速器芯片的开发。特斯拉主要围绕自动驾驶需求,迄今为止推出了两款AI芯片:全自动驾驶(FSD)芯片和Dojo D1芯片。Meta披露已经打造一款定制芯片,简称MTIA,用于加快生成式AI模型的训练。

👍

楼主残忍的关闭了评论