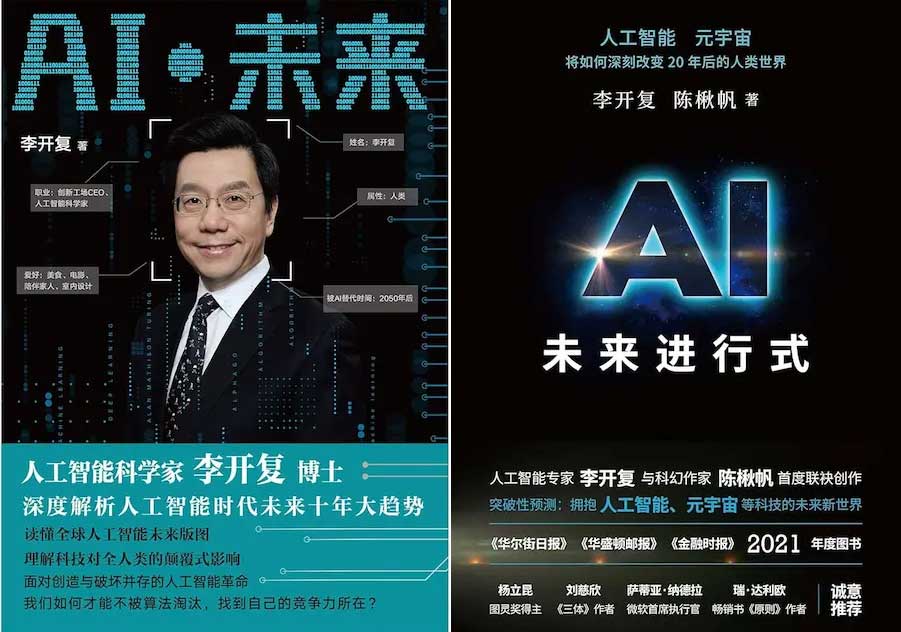

阮一峰在科技爱好者周刊(第 330 期)中结合李开复的《AI·未来》(浙江人民出版社,2018)和《AI·未来进行式》(浙江人民出版社,2022)两本书,梳理了书中阐述的人工智能概念。

李开复(Kai-Fu Lee)本是一名计算机科学家,获得哥伦比亚大学计算机科学学士学位和卡内基梅隆大学计算机科学博士学位,主要研究语音识别,曾在Apple和Silicon Graphics的技术部门工作,并领导Microsoft和Google的中国部门。在打工近20年后,李开复建立了风险投资基金创新工场(Sinovation Ventures),为早期互联网初创公司提供种子资金。2023 年,李开复创立了人工智能初创公司 01.AI,专注于为中国市场构建大型语言模型。

李开复长期工作和居住在中国北京,为致力于帮助中国年轻人学习和就业写过很多书树立人设,支持中国是人工智能领域的全球领导者(见《人工智能超级大国》一书),这一路径有点类似泅水离台的北京大学国家发展研究院名誉院长林毅夫。林毅夫是新结构经济学的创始人之一,并积极参与中国的经济政策研究与制定。

以下是正文。

(1)人工智能

1956年夏天,计算机科学家约翰·麦卡锡(John McCarthy)首次提出"人工智能"(AI)这个概念。

人工智能指的是,通过软件和硬件,来完成通常需要人类智能才能完成的任务。它的研究对象,就是在机器上模拟人类智能。

(2)机器学习

早期,人工智能研究分成两个阵营。

第一个阵营是规则式(rule-based)方法,又称专家系统(expert systems),指的是人类写好一系列逻辑规则,来教导计算机如何思考。

可想而知,对于复杂的、大规模的现实问题,很难写出完备的、明确的规则。所以,这种方法的进展一直很有限。

第二个阵营就是机器学习(machine learning),指的是没有预置的规则,只是把材料提供给计算机,让机器通过自我学习,自己发现规则,给出结果。

(3)神经网络

神经网络(neural network)是机器学习的一种主要形式。

神经网络就是在机器上模拟人脑的结构,构建类似生物神经元的计算网络来处理信息。

一个计算节点就是一个神经元,大量的计算节点组成网络,进行协同计算。

神经网络需要极大的算力,以及海量的训练材料。以前,这是难以做到的,所以20世纪70年代开始,就陷入了停滞,长期没有进展。

(4)深度学习

深度学习是神经网络的一种实现方法,在20世纪80年代由杰弗里·辛顿提出。它让神经网络研究重新复活。

深度学习是一种让多层神经元可以进行有效计算的方法,大大提高了神经网络的性能。"深度学习"这个名字,就是比喻多层神经元的自主学习过程。

多层神经元包括一个输入层和一个输出层,它们之间有很多中间层(又称隐藏层)。以前,计算机算力有限,只能支撑一两个中间层,深度学习使得我们可以构建成千上万个中间层的网络,具有极大的"深度"。

(5)Transformer

早些年,深度学习用到的方法是卷积神经网络(CNN)和循环神经网络(RNN)。

2017年,谷歌的研究人员发明了一种新的深度学习处理方法,叫做 Transformer(转换器)。

Transformer 不同于以前的方法,不再一个个处理输入的单词,而是一次性处理整个输入,对每个词分配不同的权重。

这种方法直接导致了2022年 ChatGPT 和后来无数生成式 AI 模型的诞生,是神经网络和深度学习目前的主流方法。

由于基于 Transformer 的模型需要一次性处理整个输入,所以都有"上下文大小"这个指标,指的是一次可以处理的最大输入。

比如,GPT-4 Turbo 的上下文是 128k 个 Token,相当于一次性读取超过300页的文本。上下文越大,模型能够考虑的信息就越多,生成的回答也就越相关和连贯,相应地,所需要的算力也就越多。

酷玛致力于通过STEM教育培养信息素养和极客精神。