随着人工智能的广泛应用,越来越多的人参与“见证奇迹”,但这方面的实践对算力的要求比较高。在精心配置一台游戏电脑的基础上,简要记录一下深度学习的硬件指南。

CPU

尽管CPU并不直接参与深度学习模型计算,但提供大于模型训练吞吐的数据处理能力,CPU的时钟速度、核心数、缓存大小和 PCIe 通道规格会显著影响 AI 训练任务的性能。

- 适用于服务器的AMD EPYC或Intel Xeon 可扩展处理器

- 适用于工作站的Intel Xeon W或AMD Threadripper PRO

CPU和主板是对应的,还应该重点考察主板的PCIe通道数,这决定了可接显卡和SSD的数量和带宽质量。

内存

尽可能获得足够容量、更高时钟频率的内存(RAM),以实现任务并改善体验(显著节省最宝贵的资源:时间),让我们专注于真正的问题而不是挖空心思寻找变通方法来避免耗尽内存。

深度学习需要多少内存?一个好的经验法则是,如果用于处理图像处理工作流程,至少与系统中的显存(VRAM)一样多的内存;如果涉及大型数据集或者其他工作,可以选择在系统中配置两倍于显存的内存。

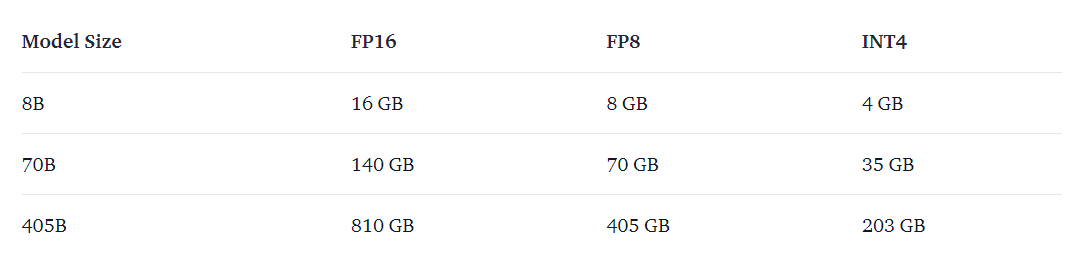

用于推理,Llama 3.1 需要多少内存?

GPU

深度学习是一个计算要求很高的领域,您对 GPU 的选择将从根本上决定您的深度学习体验。在深度学习领域,GPU彻底改变了复杂计算任务的速度和效率,其关键规格包括:

- GPU 核心 - 对于 NVIDIA 而言,它们是 CUDA 核心;对于 AMD GPU 而言,它们是流处理器。

- 内存大小和带宽。

GPU的选择方向:

- NVIDIA 在 GPU 市场占据主导地位,尤其是在深度学习和复杂神经网络方面。

- 优先选择 Volta、Turing 或者 Ampere 架构中兼具 CUDA cores 和 Tensor Core 的显卡。

建议:

- 适用于大型企业数据中心 - 多台NVIDIA H100服务器

- 对于小型数据中心 - 多个NVIDIA L40S或RTX 6000 Ada

- 适用于高性能工作站 - 多台RTX 6000 Ada

对于发烧级性能和修补来说 - 一块RTX 4090就足够了。

SabrePC:人工智能的硬件要求

以下是AutoDL帮助文档中的GPU选型,也是AutoDL AI算力云实际配置的品种。

| 型号 | 显存 | FP32 | FP16 | 说明 |

|---|---|---|---|---|

| Tesla P40 | 24GB | 11.76 T | 11.76 T | 比较老的Pascal架构GPU,对于cuda11.x之前且对大显存有需求的算法是非常不错的选择 |

| TITAN Xp | 12GB | 12.15 T | 12.15 T | 比较老的Pascal架构GPU,用作入门比较合适 |

| 1080 Ti | 11GB | 11.34 T | 11.34 T | 和TITANXp同时代的卡,同样适合入门,但是11GB的显存偶尔会比较尴尬 |

| 2080Ti | 11GB | 13.45 T | 53.8 T | 图灵架构GPU,性能还不错,老一代型号中比较适合做混合精度计算的GPU。性价比高 |

| V100 | 16/32GB | 15.7 T | 125 T | 老一代专业计算卡皇,半精性能高适合做混合精度计算 |

| 3060 | 12GB | 12.74 T | 约24T | 如果1080Ti的显存正好尴尬了,3060是不错的选择,适合新手。 |

| A4000 | 16GB | 19.17 T | 约76T | 显存和算力都比较均衡,适合进阶过程使用。 |

| 3080Ti | 12GB | 34.10 T | 约70T | 性能钢炮,如果对显存要求不高则是非常合适的选择。 |

| A5000 | 24GB | 27.77T | 约117T | 性能钢炮,如果觉得3080Ti的显存不够用A5000是合适的选择,并且半精算力高适合混合精度。 |

| 3090 | 24GB | 35.58 T | 约71T | 可以看做3080Ti的扩显存版。性能和显存大小都非常够用,适用性非常强,性价比首选。 |

| A40 | 48GB | 37.42 T | 149.7 T | 可以看做是3090的扩显存版。算力和3090基本持平,因此根据显存大小进行选择。 |

| A100 SXM4 | 40/80GB | 19.5 T | 312 T | 新一代专业计算卡皇,除了贵没缺点。显存大,非常适合做半精计算,因为有NVLink加持,多卡并行加速比非常高。 |

.

大模型的参数量和浮点精度决定了显存需求量,Huggingface 的 accelerate 开发库中提供一个显存需求评估工具accelerate estimate-memory,只需要提供模型名称或地址,就可以根据数据类型和量化精度得出结论,支持在线访问和本地运行。

如果显存有限,可以通过量化技术将模型参数从浮点数转换为低精度格式(如8位整数),从而减少模型所需的显存。这种方法可能会导致一定的性能损失,但在某些情况下足以使模型适应显存限制。另外,模型通常同步提供参数较少的替代模型,以适应可用的显存。可以对比较大模型的量化版本和较小模型两者的效果,再决定采用。

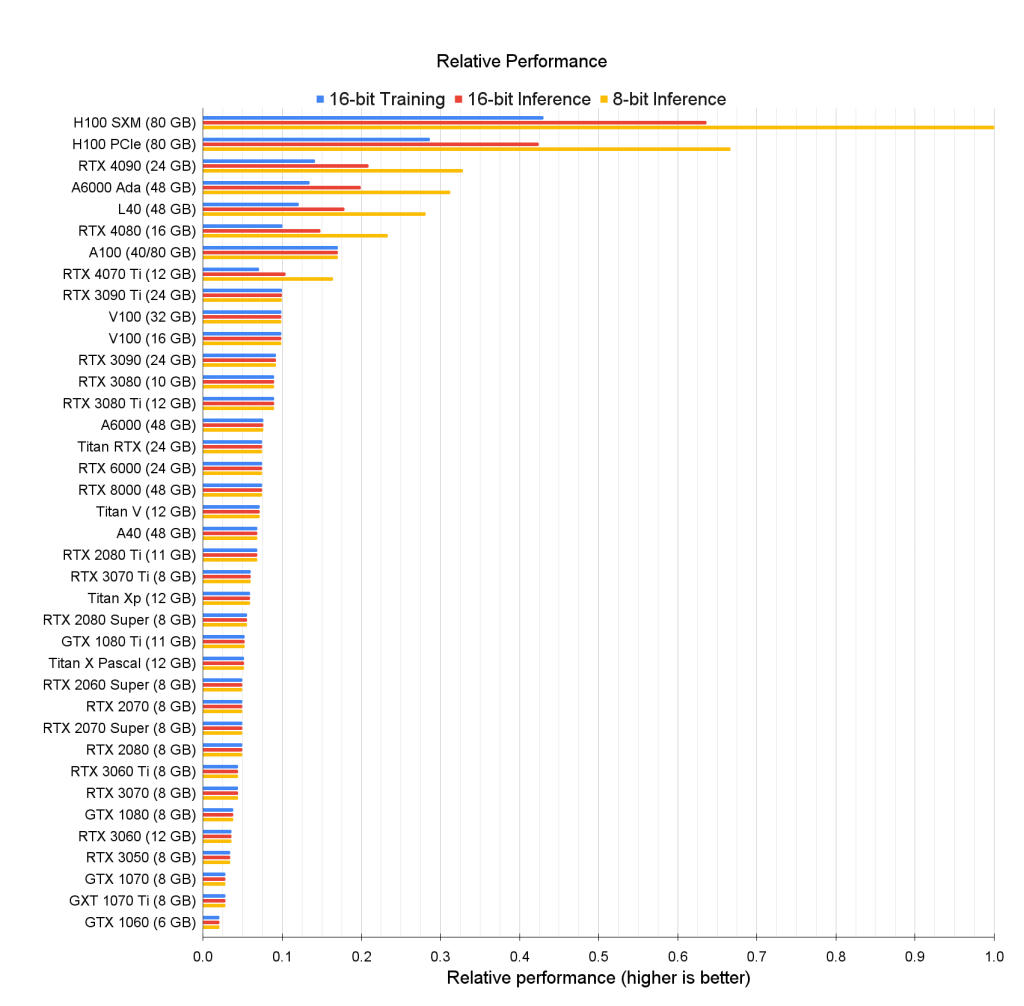

持续追踪GPU AI算力的评测博主 Tim Dettmers 对截至2022年的可选GPU列表如下:

按照Tim Dettmers的研究,GPU的重要性排序:Tensor Core 最为重要,其次是 GPU 的内存带宽、缓存层次结构,最后是 GPU 的 FLOPS。

GPU 的选择是比较复杂的事情,需要综合计算需求、成本和 GPU 本身的诸多参数表现。

- 由于 Pascal 架构的旧代 GPU 价格便宜,适合练习或调试。

- Ampere 架构的卡需要 cuda11.1 及以上才能使用,请使用较高版本的框架。

- 虽然价格是一个极大的参考因子,但 GPU 的算力参数不可忽视,防止硬件配置不能满足实际需求,可参考《人工智能超算中心的高性能处理芯片》和《Jetson Nano 2GB 开发套件动手玩》中相关章节。

- 显卡的算力单位基础知识请浏览《浮点数的双精度、单精度和半精度》。

为了体验人工智能大模型推理,本文作者使用的是华硕 TURBO-RTX2080TI-11G。在有显存焦虑的时候,可以换用同级显卡 TITAN RTX,它有相对更多的CUDA核心数、Tensor核心数和显存(24GB)。

使用总结:NVIDIA GeForce RTX 2080 Ti 在 AI 推理中表现良好,但其 11 GB 内存和较低的计算能力限制了其在超大型模型或实时高分辨率任务中的应用。

最后的建议

由于主流深度学习硬件由NVIDIA供应,需要集中了解 NVIDIA 支持 CUDA 的 GPU 卡列表、GeForce显卡官方技术对比(以及Technical City的NVIDIA显卡排行榜和KCORES 大语言模型推理专用显存天梯)。尽量选择NVIDIA TITAN Xp和GeForce RTX 2060及更新的显卡,同时有12GB及以上显存和支持Tensor Core更好。

在此我们更关注消费级显卡。NVIDIA GeForce 系列消费级显卡主要的设计应用场景是游戏和图形渲染,也可以用于消费级 AI 推理。

RTX 20系列(Turing架构)的FP16和FP32计算单元是分开的。每个CUDA核心可以执行一个FP32操作或两个FP16操作。这意味着在FP16模式下,算力是FP32模式的两倍。

RTX 30系列(Ampere架构)和RTX 40系列(Ada Lovelace架构)引入了统一的计算单元,这些单元可以同时处理FP16和FP32操作。这意味着每个CUDA核心在FP16和FP32模式下的算力是相同的。

具体来说,半精度可用于AI的深度学习和机器学习 (ML) ,研究表明,许多机器学习模型可容许较低精度的算法而不降低收敛准确性。但单精度(FP32)对应影音处理,在处理复杂的图形比如渲染照片般逼真的动态环境时,您需要NVIDIA GeForce RTX 3090以上算力的显卡(单精度算力接近或超过40 TOPS)——目前来看也只有RTX 3090、3090 Ti、4070 Ti、4080和4090。

AI服务器根据应用需求不同分为深度学习训练型和智能应用推理型,训练任务需要高密度算力支持,推理任务对算力的要求却可能比你想象的更低,甚至一些AI应用只需要CPU就可以运行。因此,如果是玩深度学习训练模型(“炼丹”)或者ChatGPT,应该投入顶级显卡 * N 或者租用网络算力;如果是本地部署一些轻量AI应用如画图、语音识别、图像修复、知识整理等推理模型,选择一张在售NVIDIA RTX显卡总是没错的。

电源

功能足够大的电源,特别是GPU会消耗更多的电能。

冷却

部署温度监控程序来监视GPU的温度,并安装GPU冷却系统确保冷却效果,机箱设计和机箱风扇都不重要。

整机的配置信息请参考《Windows 95后的个人电脑参考配置》,包含个人电脑兼顾视频游戏和AI推理任务的最新信息。

新的选择

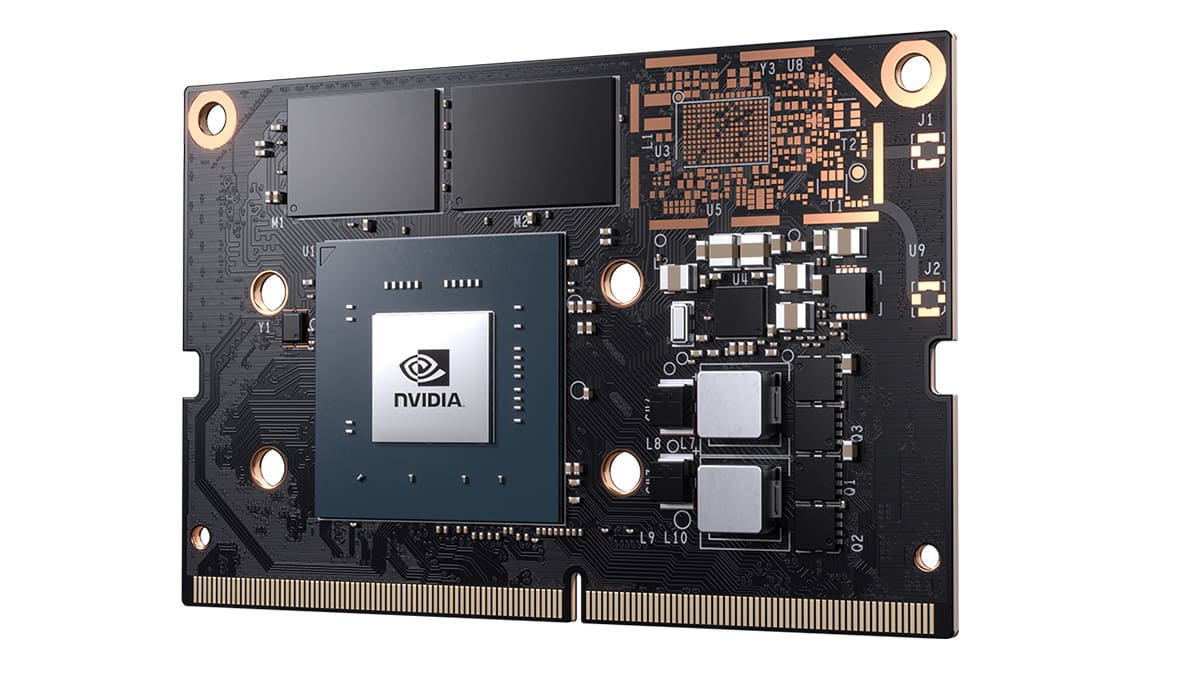

NVIDIA Jetson Nano

对于创客、初学者和嵌入式开发者,建议使用NVIDIA® Jetson Nano,提供472 GFLOPS的计算性能。

NVIDIA Jetson Orin Nano

2024年12 月 17 日英伟达推出Jetson Orin Nano Super Developer Kit,这款开发者套件通过免费软件升级Jetson Orin Nano Developer Kit,实现了更高性能和更低价格。

软件升级后Jetson Orin Nano的算力值为67 INT8 TOPS,足够使其作为物联网设备、移动设备等边缘设备进行实时推理,可以无缝运行最流行的生成式 AI 模型,例如视觉转换器、大型语言模型、视觉语言模型等。

Copilot+ PC

如果您仔细关注,市场上已经出现了许多具有一定算力的边缘和移动设备,可以作为个人深度学习的硬件备选项。

Microsoft Surface(Copilot+ PC 始于 第 11 代 Surface Pro 和第 7 代 Surface Laptop)

ASUS NUC 14 Pro AI(ASUS 华硕生产的第一款 NUC)

近十多年来,微软持续推动Windows On Arm、AI PC和Copilot+ PC战略,市场将有更多 Copilot+ PC 出现。微软对Copilot+ PC的功能规定,硬件 AI 算力要达到 40+ TOPS(大约是RTX 3090的算力档次,渲染照片般逼真的动态环境将需要大约 40 TOPS)。

NVIDIA Project DIGITS

2025 年 1 月 6 日,NVIDIA 推出了 NVIDIA® Project DIGITS,这是一款个人 AI 超级计算机,采用全新的 NVIDIA GB10 Grace Blackwell 超级芯片,提供千万亿次的 AI 计算性能,可用于原型设计、微调和运行大型 AI 模型。

NVIDIA® Project DIGITS将是AI一体机的代表作。

👍

楼主残忍的关闭了评论