微软微软宣布推出一款专为人工智能设计的全新 Copilot+ PC,使用Arm架构的高通处理器。ARM 成就了 AI PC。

2012年,三星发布了第一款采用Arm架构的Chromebook,这款电脑搭载了三星Exynos 5250芯片。

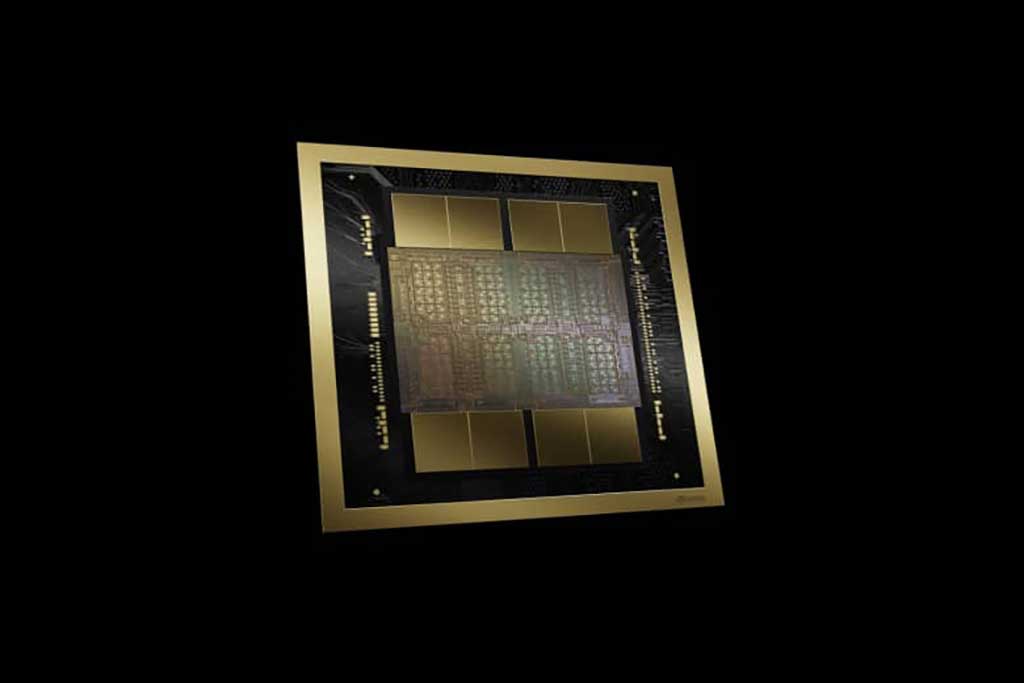

在 NVIDIA GTC 2024 主题演讲中,黄仁勋推出了Blackwell B200 张量核心芯片,这是该公司最强大的单芯片 GPU,拥有 2080 亿个晶体管,Nvidia 声称该芯片可以将 AI 推理运营成本(例如运行ChatGPT)和能耗比前辈H100降低多达 25 倍。该公司还推出了 GB200,这是一款“超级芯片”,结合了两个 B200 芯片和一个 Grace CPU,可提供更高的性能。

这一消息是 Nvidia 年度 GTC 会议的一部分,该会议将于本周在圣何塞会议中心举行。英伟达首席执行官黄仁勋周一下午发表了主题演讲。“我们需要更大的 GPU,”黄仁勋在主题演讲中说道。他说,Blackwell 平台将允许训练万亿参数的人工智能模型,这将使当今的生成式人工智能模型相比之下显得很初级。作为参考,OpenAI 于 2020 年推出的 GPT-3 包含 1750 亿个参数。参数数量是 AI 模型复杂性的粗略指标。

《哈佛商业评论》在 2017 年发表过一组大创意系列文章,包括Erik Brynjolfsson和Andrew McAfee写的《真实的人工智能》。在那个仅有AlphaGo战胜人类围棋选手一条关键词新闻的年度(而不是“人工智能元年”或者今天),这篇文章对人工智能的分析值得回顾。

250多年来,经济增长的根本动力一直是技术创新。其中最重要的是经济学家所说的通用技术——这一类别包括蒸汽机、电力和内燃机。每一个都催生了互补性创新和机遇的浪潮。例如,内燃机催生了汽车、卡车、飞机、链锯和割草机,以及大型零售商、购物中心、越库仓库、新的供应链,而且,当你想到这一点时,郊区。沃尔玛、UPS 和 Uber 等多元化公司都找到了利用该技术创建有利可图的新商业模式的方法。

在世界工业机器人业界中,以瑞士的ABB、德国的库卡(KUKA)、日本的发那科(FANUC)和安川电机(YASKAWA)最为著名,并称工业机器人四大家族。四大家族在各个技术领域内各有所长,ABB 的核心领域在控制系统,KUKA 在于系统集成应用与本体制造,发那科在于数控系统,安川在于伺服电机与运动控制器领域。参看OFweek文章《工业机器人四大“豪门”到底哪家强?》。

ROS全名 Robot Operating System,即机器人操作系统。一家名为Willow Garage的公司,对斯坦福人工智能机器人项目中的软件系统进行了扩展和完善,在2007年推出了ROS。2013年,ROS被OSRF开源机器人基金会(Open Source Robotics Foundation)接管。

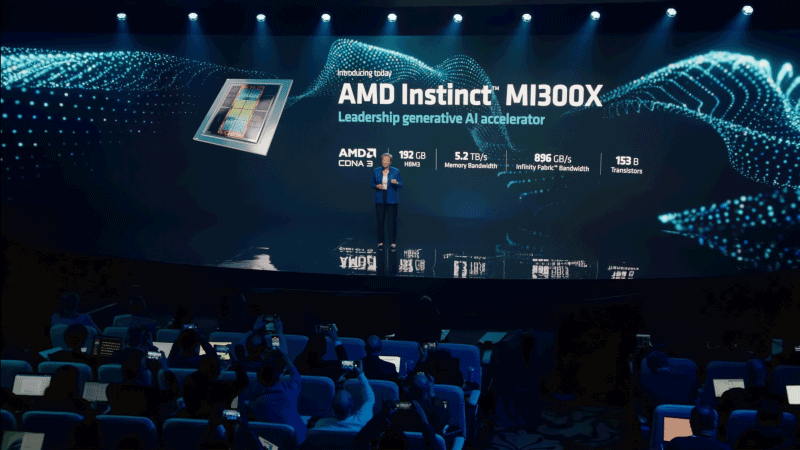

2023年6月13日,AMD发布其最先进的用于人工智能的GPU芯片MI300X,并称将于今年晚些时候向部分客户供货。AMD 的 Instinct MI300 系列包括Instinct MI300A 和MI300X 两种。MI300A 包含CPU 与GPU,而MI300X 则是纯GPU 的加速模组,功耗高达750W。相比MI250X,MI300的AI性能(TFLOPs)提高了8倍,而前者是383TFLOPs,也超过了NVIDIA H100。(via xfastest.com)

当OpenAI/ChatGPT概念风行之时,激发了一些人的AI奇想,比如:

要实现这些AI奇想,需要通用人工智能(Artificial General Intelligence,AGI,强人工智能)和 AI 代理(AI agent或者Intelligent agent),它感知环境,自主采取行动以实现目标,并可以通过学习或获取知识来提高其性能。Auto-GPT就是一个AI 代理。