本地部署人工智能模型,不仅通过重视和利用资源赋予个人权力,而且还培育出更加分散和民主的数字生态系统。也就是说,不仅增强了隐私和安全性,还引入了个人计算作为数字时代潜在货币的有趣概念。

Ollama是一个易用的本地语言模型运行框架,可以一键启动并运行Meta Llama 3、Microsoft Phi 3、Google Gemma 2和其他更多开源语言模型(官方模型库也是一份很棒的开源语言模型清单,和NVIDIA提供的最受欢迎的基础模型列表一样,总是汇总支持的最新模型信息),并支持自定义模型导入。Ollama旨在简化在本地硬件上运行大型语言模型的过程,支持GPU加速以提升推理性能。本文基于 Windows 11 + 64 GB + RTX 2080 Ti + Llama 3.x + Cherry Studio 实践。

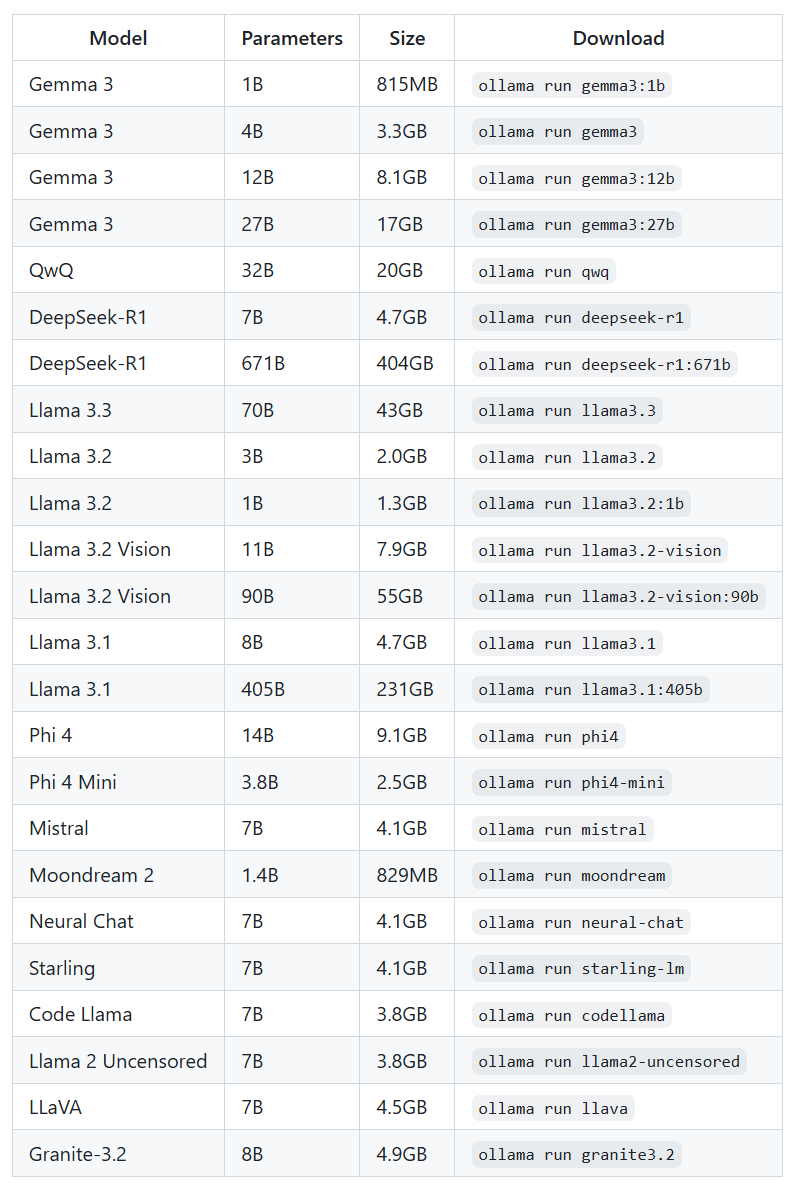

一些最新开源模型,官方存储库更新至2025-03-14。较新推荐gpt-oss、deepseek-r1、gemma3、qwen3和llama3.1(2025-09-25)。

关于开源模型库

Ollama随时更新支持的开源模型库,如果您希望选择“更聪明的”模型,可以实时参考Chatbot Arena LLM排行榜,您还可以发现,在所有模型中,最聪明的总是商业模型。

2025年1月22日,Ollama更新模型列表,支持号称在数学、代码和推理任务中性能与 OpenAI-o1 相当的 DeepSeek 第一代推理模型。深度求索(DeepSeek)是由中国对冲基金幻方(High-Flyer)创立和支持的人工智能公司,该公司已将其模型作为开源发布,以低廉的价格提供了强大的性能。在Vibe-Eval基准测试中,DeepSeek是迄今为止排名最高的公开授权模型,也是目前最大的公开授权模型,其 671B 的体量比 Meta 公司最大的 Llama 系列模型 Llama 3.1 405B 还要大得多。

安装

在官方库中下载Windows和macOS安装包、或者Docker镜像运行,Linux直接执行命令行安装curl -fsSL https://ollama.com/install.sh | sh

快速开始

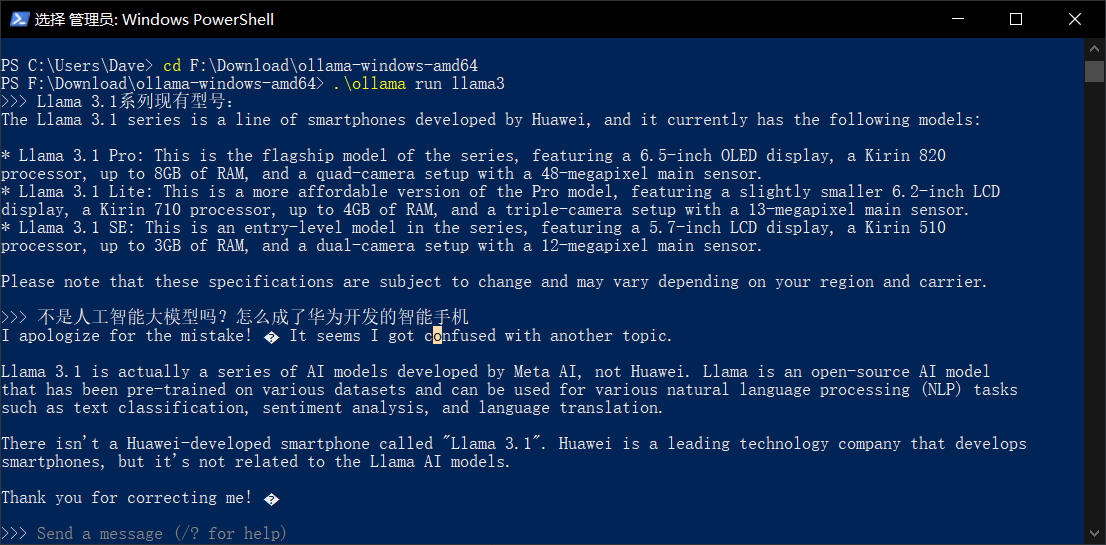

以运行 llama 3 8B 为例:

ollama run llama3

llama 3 的自我介绍:This version was trained on a massive dataset of text from the internet and is designed to generate human-like responses to a wide range of topics and prompts.

2024年7月23日,Meta发布Llama 3.1,依旧有 8B、70B 和 405B 参数尺寸可供选择,这是对4月发布的Llama 3的重大更新,开始对中文支持较好。Llama 3.1 8B 和 70B 模型的升级版本是多语种的,其上下文长度大幅增加到 128K,工具使用达到了最先进的水平,整体推理能力也更强。这使其能够支持高级用例,如长文本摘要、多语种对话代理和编码助手。Llama 3.1 405B 在常识、可转向性、数学、工具使用和多语言翻译等方面具有最先进的能力,可与顶级人工智能模型相媲美。Llama 3.1 在某些基准测试中是地球上最聪明的人工智能。Ollama 实时支持 Llama 3.1。

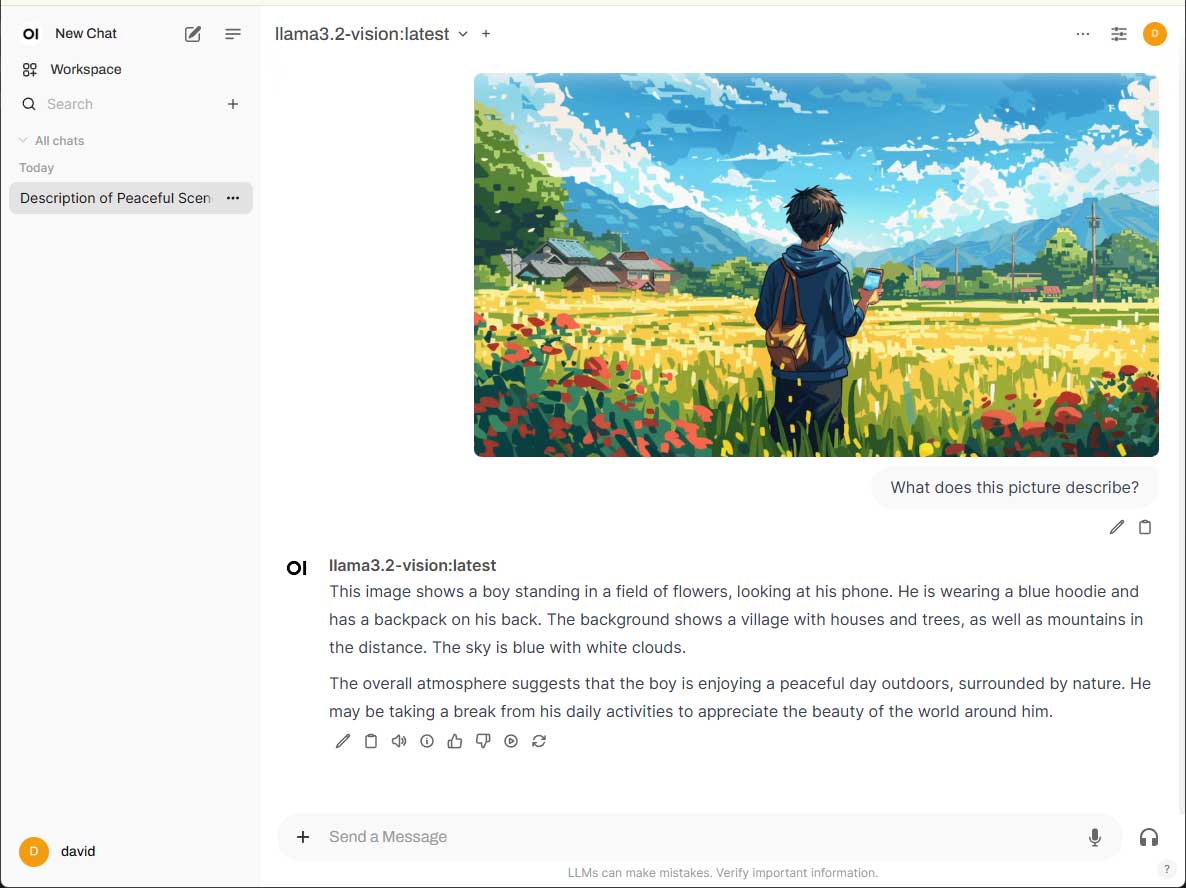

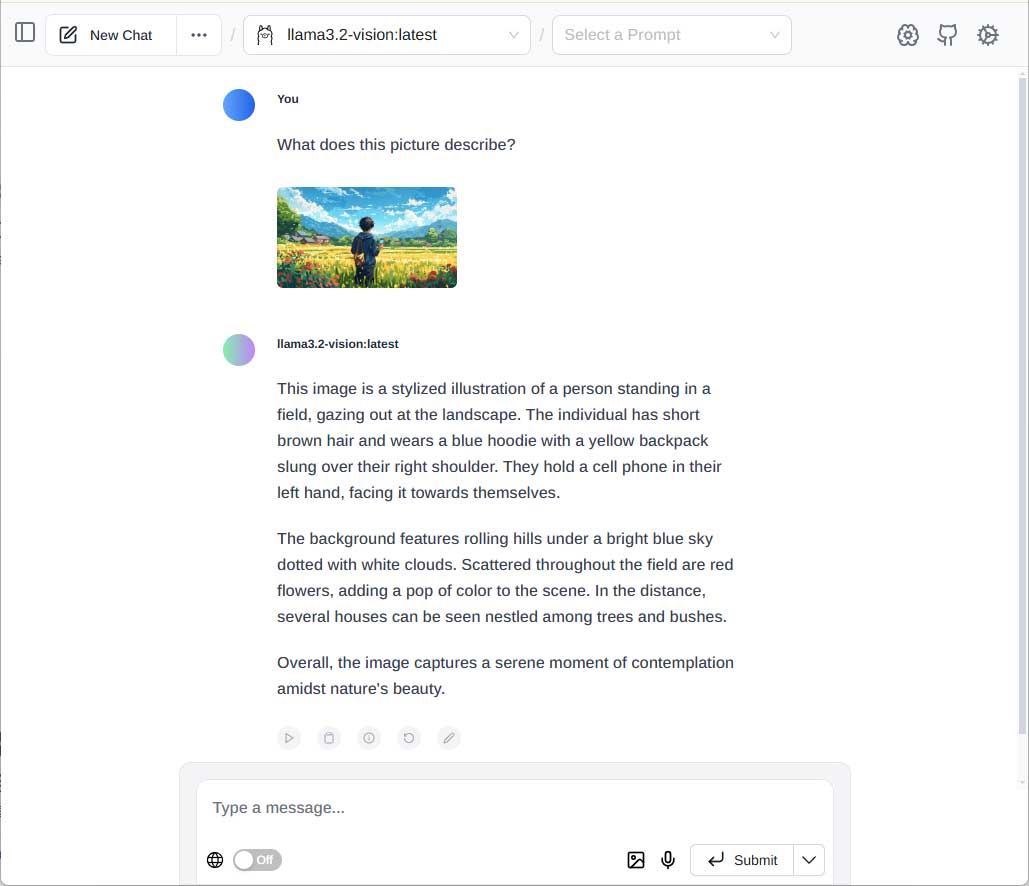

2024 年 9 月 25 日,Meta发布Llama 3.2,包括多语言纯文本模型(1B、3B)和文本图像模型(Vision 11B、Vision 90B),多语言纯文本模型适合在移动设备和边缘设备上运行。文本图像模型则支持图像推理用例,可以根据可用的图表进行推理并快速提供答案。注意:Llama 3.2 Vision 11B 至少需要 8GB VRAM,而 90B 型号至少需要 64 GB VRAM。Llama 3.2-Vision 多模态大型语言模型对于纯文本任务,官方不支持中文;对于图像+文本应用程序,英语是唯一支持的语言。Ollama实时支持Llama 3.2,推荐Llama 3.2 Vision 11B。

2024 年 12 月 6 日Meta发布Llama 3.3 70B,与Llama 3.1 405B 相当,但成本和计算开销小得多。Ollama实时支持Llama 3.3 70B。

官方还分享了第一个实验性的Llama Stack,这是一套标准化工具和 API,将极大地简化构建和部署大型语言模型应用程序的过程。

- 如果模型不存在,会自动下载模型。

- 应该至少有8 GB的内存来运行7B型号,16 GB的内存来运行13B型号,32 GB的内存来运行33B型号。虽然本文基于Windows实践,但更建议在配备现代多核 CPU 和高内存 GPU 的台式机及 Linux 系统中部署和操作;如果没有更大的内存,不要尝试Llama 3.1 70B这样的大尺寸模型。

- 除了系统内存容量,显存(GPU VRAM)大小更是需要考虑的。研究表明,模型的VRAM需求通常接近其文件大小(加上一定的开销约需2倍文件大小),以覆盖推理过程中的额外VRAM使用。由于Ollama默认使用4位量化,降低了内存需求,同时,运行其中的模型基于GGUF格式的4位量化后总VRAM需求也会减少。经过测试,在32GB系统内存和RTX2080TI-11G显卡的配置情况下,已稳定快速运行Llama 3.1 8B、Llama3.2-vision 11B和Phi-4 14B,Deepseek-r1 14B以下的蒸馏版本也没有问题。

交互

简单交互

模型运行之后,会默认进入到交互状态,还包含一个用于运行和管理模型的 REST API 可用。

社区交互项目

围绕 Ollama 生态,还有一大批项目可实现与模型对话,包括桌面客户端、web 客户端、命令行终端、第三方应用(如浏览器)扩展和插件等,如需要自托管的 Ollama WebUI(已经更名为 Open WebUI)就是一个使用下载的模型文件与 Ollama 交互的流行界面,功能丰富且用户友好。Open WebUI功能多,项目庞大,更多详情请查看项目说明。

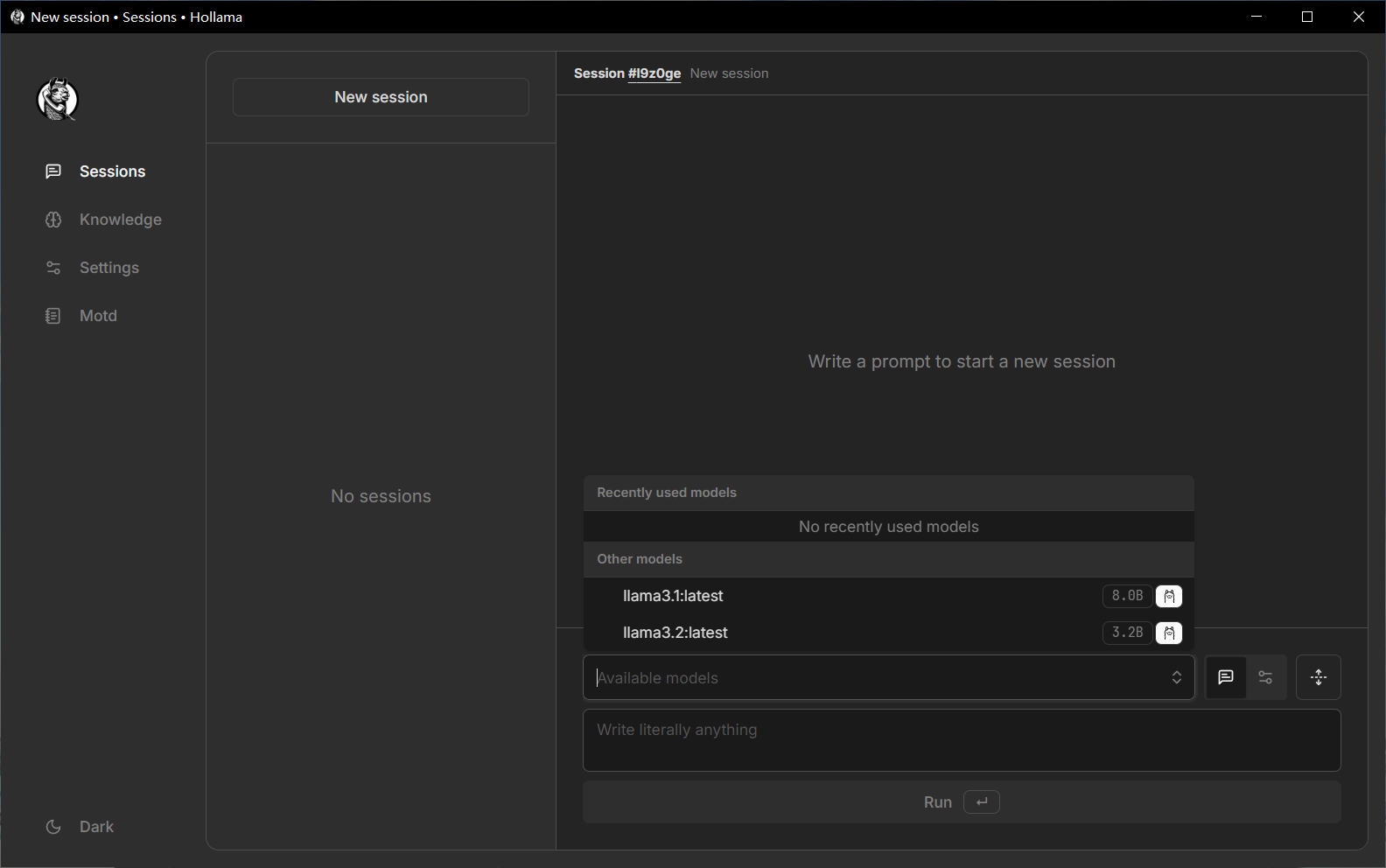

Hollama

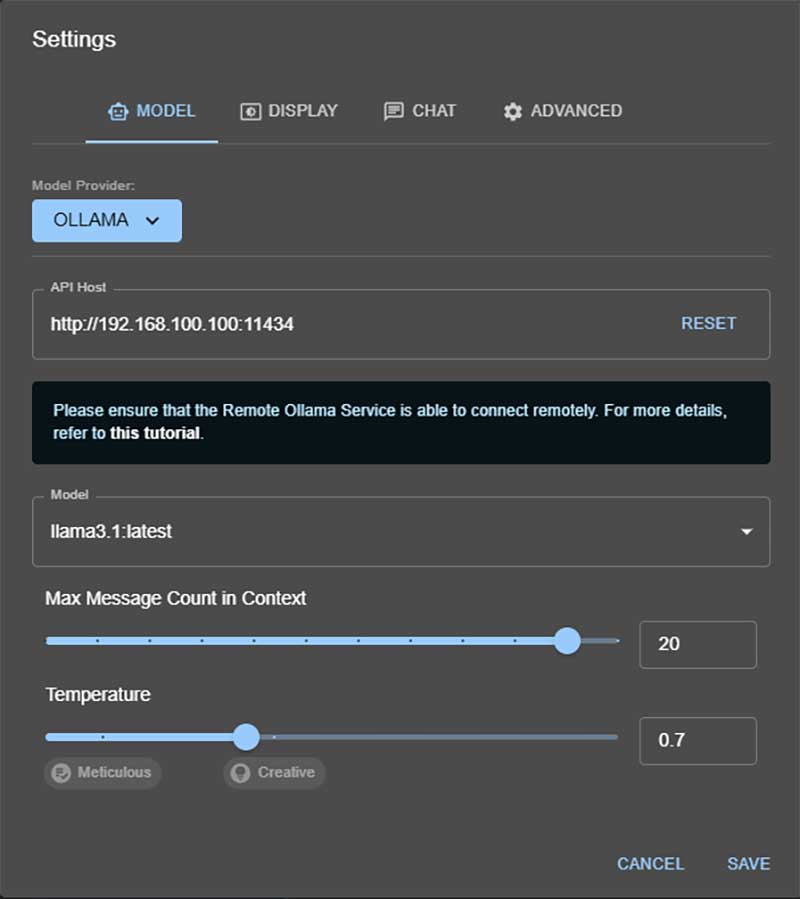

对于Windows用户来说,可能最习惯的还是使用图形化的桌面客户端。我测试了一些Windows桌面端界面,功能简洁的如Hollama、Ollama App等,还有集成其他丰富功能并内置众多API服务商接入的如Cherry Studio、ChatWise、Chatbox等,都很好用。

Ollama不仅在本地运行,还可以以API的方式提供远程服务,为客户端的多元化提供机会。

原生图形界面

Ollama v0.10.0 开始提供全新的图形界面,不再仅仅依赖命令行模式和第三方交互窗口。

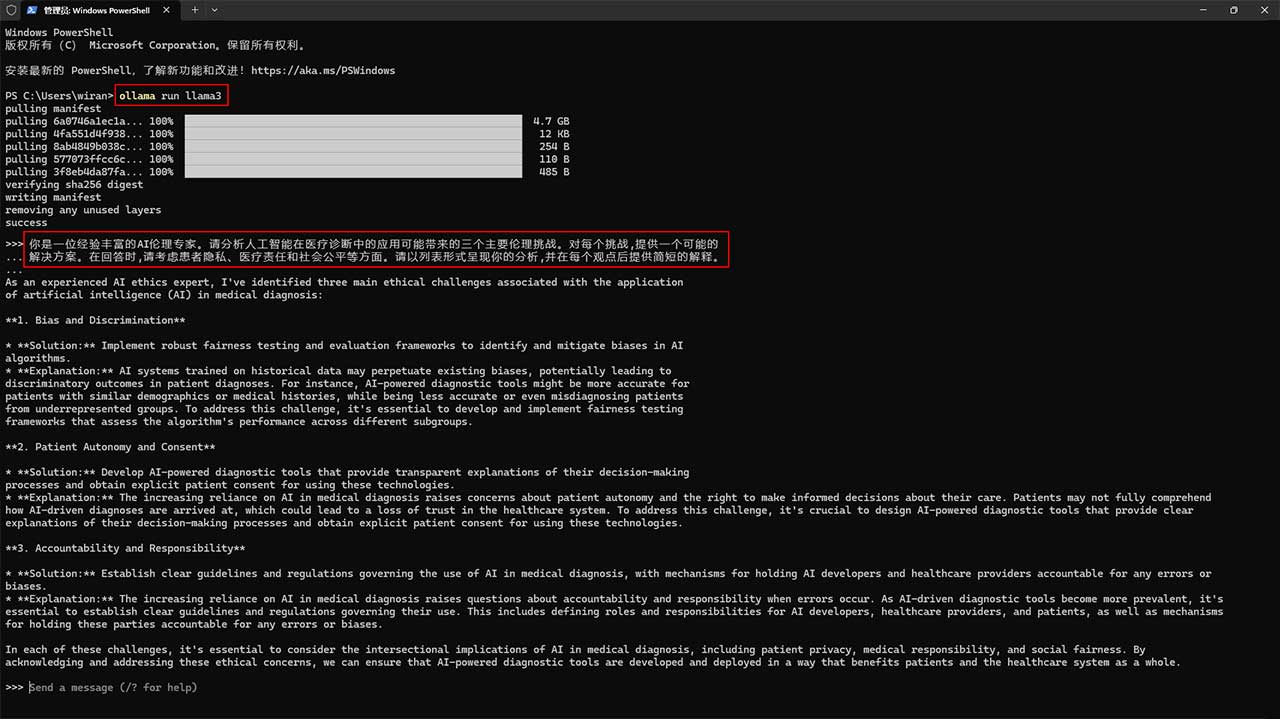

完整演示

步骤说明:

1、安装Ollama:Windows 11 23H2,32.0 GB 内存,安装Windows安装包 OllamaSetup.exe(272 MB)。

安装后,通过检查版本来验证 Ollama 是否正确安装:ollama --version。2024年7月14日最新发布版本为v0.2.5。2、下载Llama 3 8B 模型(4.7 GB):ollama run llama3

初次运行Ollama,模型并不存在,会自动下载模型Llama 3 8B。下载完成后,进入到Llama 3交互状态。

3、输入prompt开始对话:

"你是一位经验丰富的AI伦理专家。请分析人工智能在医疗诊断中的应用可能带来的三个主要伦理挑战。对每个挑战,提供一个可能的解决方案。在回答时,请考虑患者隐私、医疗责任和社会公平等方面。请以列表形式呈现你的分析,并在每个观点后提供简短的解释。"

这可能是一个综合性的经典prompt,包含了角色设定、任务描述、输出格式要求、知识范围限定、多角度分析要求等多个元素,能够有效地引导模型生成结构化、深入的回答。

4、结果评价(摘要):

- 偏见和歧视

根据历史数据训练的人工智能系统可能会延续现有的偏见,从而可能导致对患者诊断的歧视性结果。要应对这一挑战,就必须开发和实施公平性测试框架,以评估算法在不同亚群体中的表现。

- 患者自主权和同意权

在医疗诊断中越来越依赖人工智能,患者可能无法完全理解人工智能驱动的诊断是如何得出的,这可能会导致患者对医疗系统失去信任。为了应对这一挑战,设计人工智能驱动的诊断工具至关重要。在使用这些技术时解释其决策过程,并征得患者的明确同意。

- 问责与责任

随着人工智能驱动的诊断工具越来越普遍,有必要制定明确的指导方针和法规来规范其使用。这包括定义人工智能开发者、医疗服务提供者和患者的角色和责任,以及在发生任何错误时追究各方责任的机制。

我认为生成结果很好(没错,Llama 3 继续对中文的支持效果欠佳,它用英文回复)。Llama 3是目前评价最高的开源语言生成模型,而Stable Diffusion 3依然是第一的开源图像生成模型。

小知识

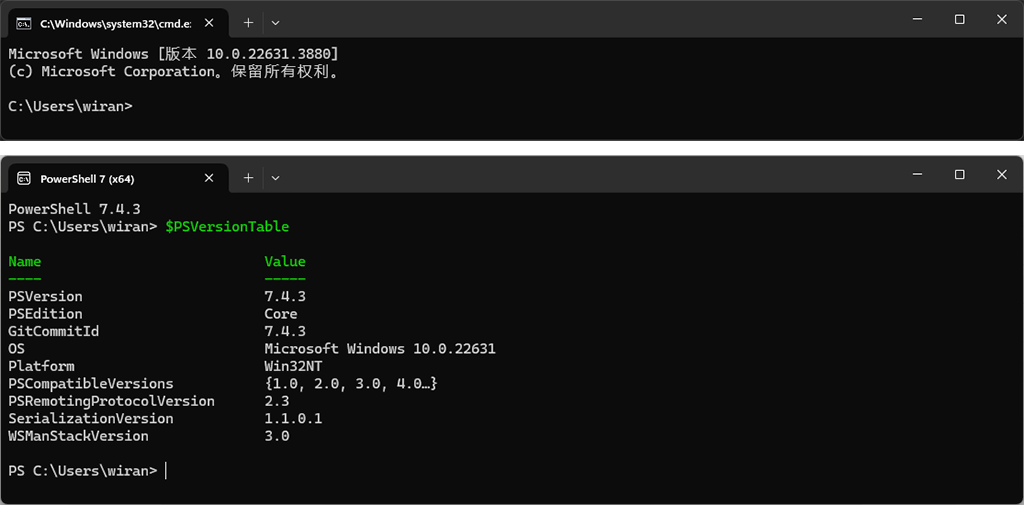

Windows命令提示符(cmd.exe)是Windows NT下的一个用于运行Windows控制台程序或某些DOS程序的Shell(为使用者提供使用界面)程序,用于替代Windows 9x系统中所提供的COMMAND.COM和“MS-DOS提示符”。命令提示符可通过点击开始菜单中的“命令提示符”或者运行(Win + R)CMD来打开窗口运行。

PowerShell 是专为系统管理员设计的新 Windows 命令行 Shell,自 Windows 10 build 14971 起,PowerShell 取代了命令提示符。Windows 中随附的 PowerShell 版本叫Windows PowerShell,但到5.1版本后就不再更新,用独立的PowerShell取代。

在Windows PowerShell中执行命令

$PSVersionTable可以查看Windows PowerShell版本,在安装最新的PowerShell 7(2024年6月18日发布PowerShell v7.4.3)后,在Windows PowerShell窗口的设置里面将命令行可执行文件配置为新的位置"C:\Program Files\PowerShell\7\pwsh.exe",即可迁移到 PowerShell 7。Windows PowerShell或PowerShell可通过开始菜单中的“终端管理员”或者运行(Win + R)PowerShell 来打开窗口运行。

更多相关请查看PowerShell 的官方产品文档。

问题

1、在进行更多基于Windows的本地部署,执行ollama run llama3时偶然遇到错误提示Error: could not connect to ollama app ……或者Error: listen tcp 127.0.0.1:11434: bind: ……。

解决办法:修改系统环境变量:OLLAMA_HOST=127.0.0.1:11435 ollama serve

2、列出已下载的模型清单:

ollama list

3、何删除已经下载的模型:

ollama rm llama3:latest # list出来的模型名

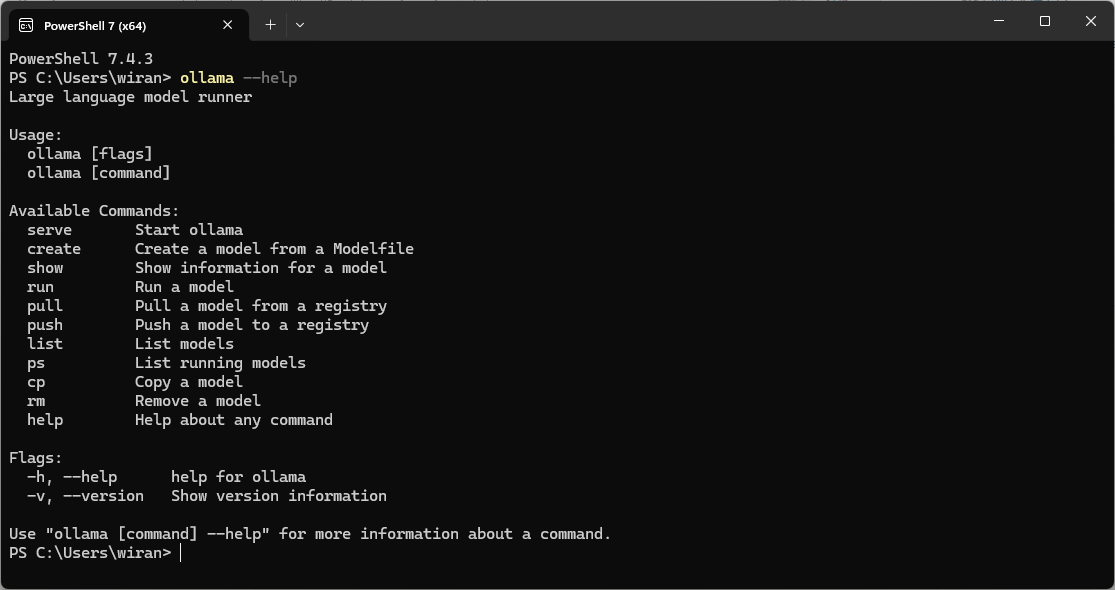

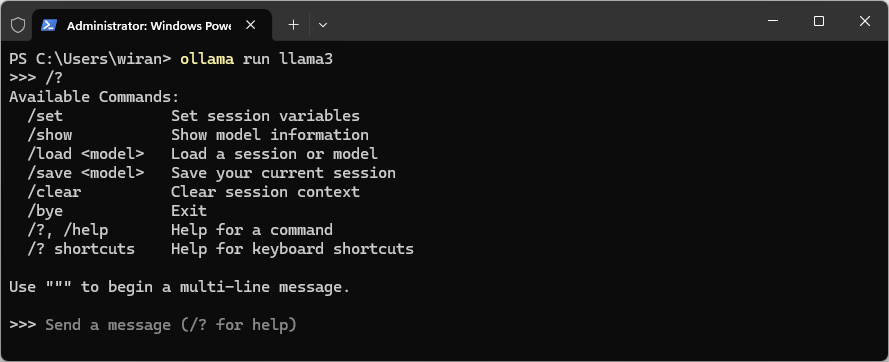

4、更多可用命令

ollama命令:

llama3命令:

5、Llama 3 说 Llama 3.1 是 Huawei 的手机系列,也许我问得不对。

后续更新

- 请保持Ollama版本更新:如果有更新,右击系统托管图标选择操作;如果无反应,重新下载新版安装文件(Windows)安装即可。

- 请保持模型更新,对于普通消费级计算机,推荐Llama 3.1 8B或者Llama 3.2 Vision 11B。

- 一些终端可能不支持Llama 3.2 Vision需要的图片导入,推荐安装自托管Open WebUI或者浏览器扩展Page Assist。

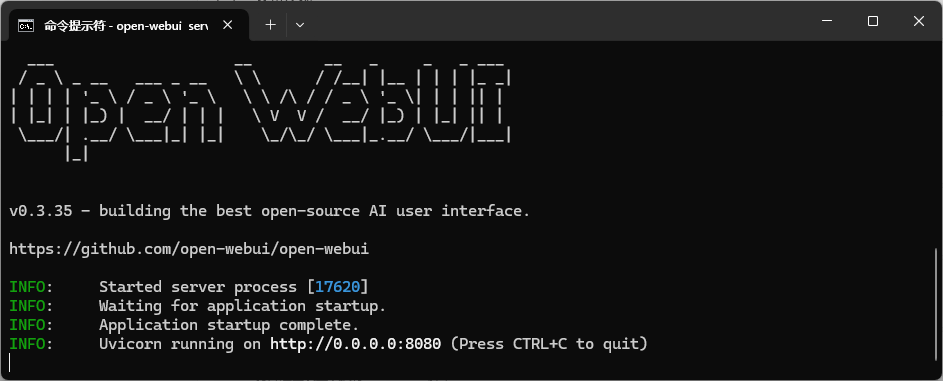

Open WebUI有丰富的功能和高度直观且易于访问的界面。打开终端并运行pip install open-webui来安装 Open WebUI,执行open-webui serve启动 Open WebUI。

Page Assist界面,就如一个简版的Open WebUI。但它是一个浏览器扩展,可以非常快速地启动它。

Ollama 的关键更新

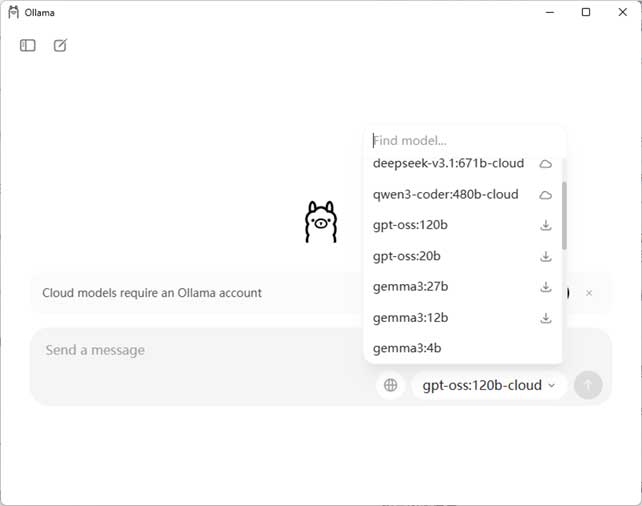

Ollama v0.12.0

Ollama v0.12.0 中可以使用云模型,让用户能够使用快速的数据中心级硬件运行个人电脑无法容纳的更大规模的模型(Ollama自带的图形界面截图显示了云模型、可下载模型和已下载模型)。现在支持四个云模型:

- gpt-oss:120b-cloud

- gpt-oss:20b-cloud

- deepseek-v3.1:671b-cloud

- qwen3-coder:480b-cloud

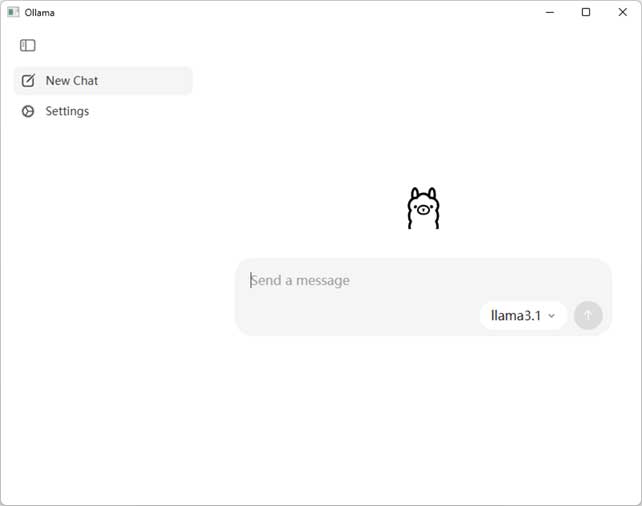

Ollama v0.10.0

Ollama v0.10.0 提供全新的图形界面,不再仅仅依赖命令行模式和第三方交互窗口。

- 模型选择、下载和聊天的更简便方法。

- 更容易使用文本或 PDF 进行推理。

- 设置中增加 Ollama 的上下文长度。

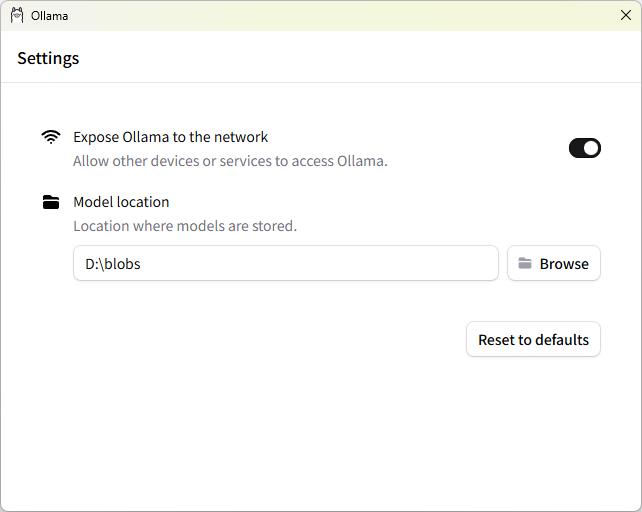

Ollama v0.9.5

Ollama v0.9.5 提供两项关键实用新功能:

- 在网络上曝光 Ollama:Ollama 现在可以公开在网络上,允许其他人联网访问 Ollama。

- 自定义模型目录:这样就可以将模型存储在外部硬盘或默认目录以外的其他目录中。

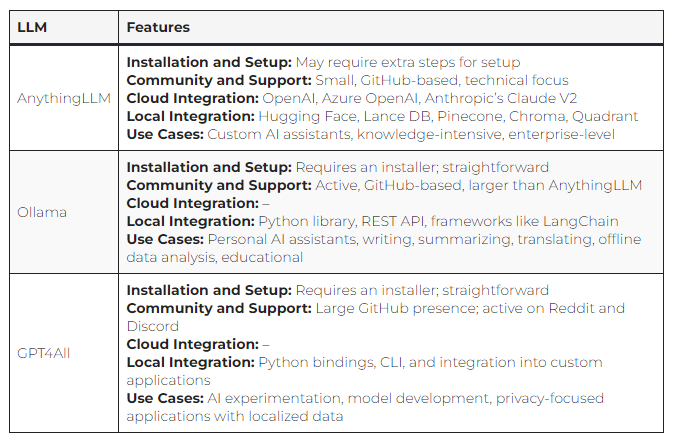

其他本地开源大模型框架

到目前为止,这些本地开源大模型框架都在发展中并获得有限的社区支持,性能都差不多。比如以下是AnythingLLM、Ollama和GPT4All的对比:

另外,llama.cpp是一个用C/C++实现的开源软件库,包含CLI和 Web 服务器,目标是在各种硬件(本地和云端)上以最少的设置和最先进的性能实现 LLM 推理,适合需要更多过程掌控的用户。

👍

楼主残忍的关闭了评论